Fakt wyświetlenia witryny w zasobach wyszukiwarki określamy mianem zindeksowania. Tylko zindeksowana witryna ma szansę dotrzeć do potencjalnych Klientów lub osób zainteresowanych zwartością strony. I nie mam tutaj na myśli, czy wyświetli się ona na wysokich, czy niskich pozycjach. Chodzi o sam fakt widoczności w wynikach wyszukiwania.

Twoja strona nie wyświetla się w Google – jak można to sprawdzić?

Na kilka sposobów:

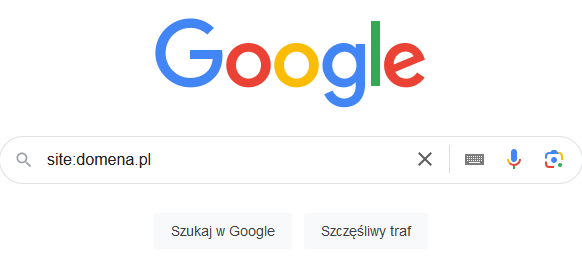

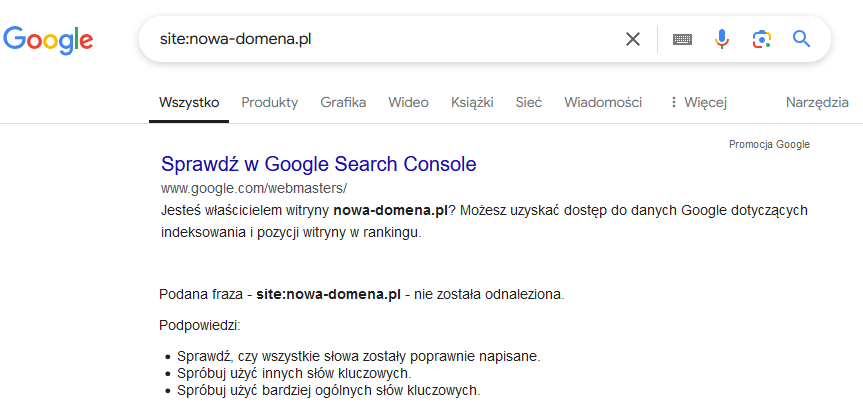

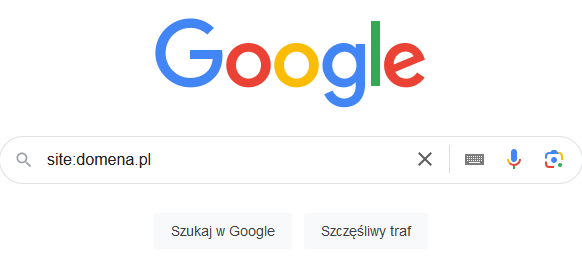

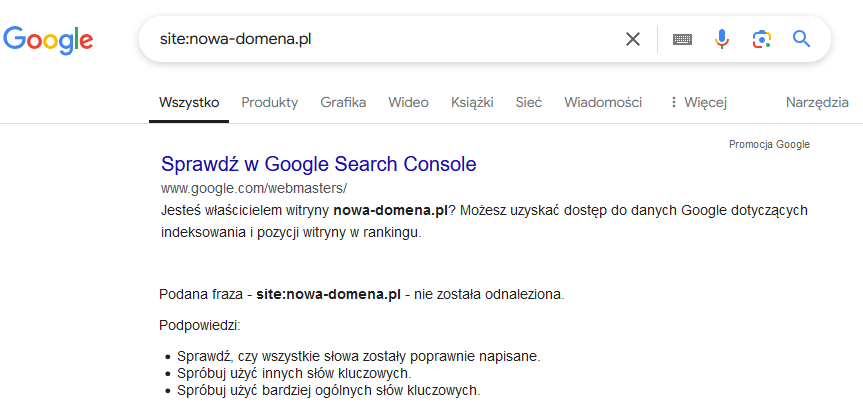

- Za pomocą komendy „site:” w wyszukiwarce:

UWAGA: nie używamy znaku „spacji” przed ani za dwukropkiem.

Jeśli wyszukiwarka w ramach wyniku zwróci listę podstron witryny, oznacza to, że strona jest indeksowana. Czy proces ten przebiega prawidłowo i w całości, to zupełnie inny temat.

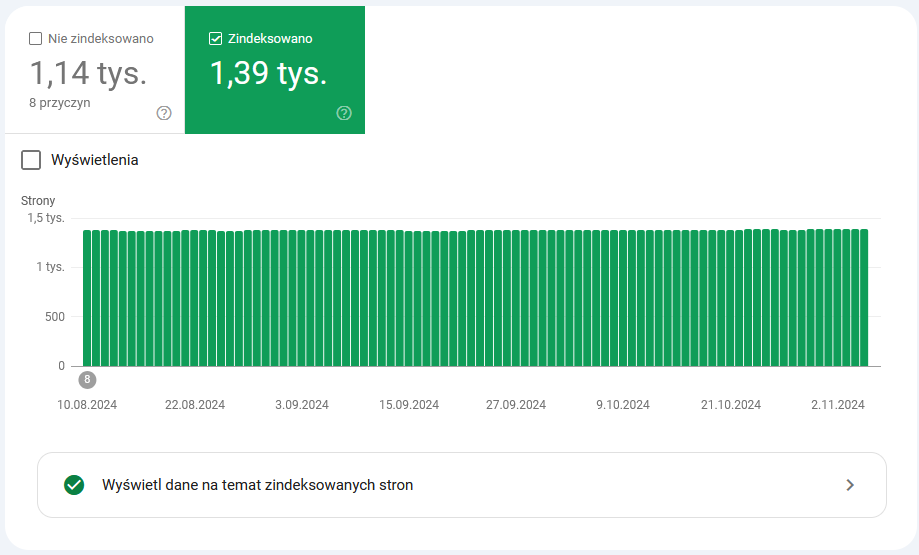

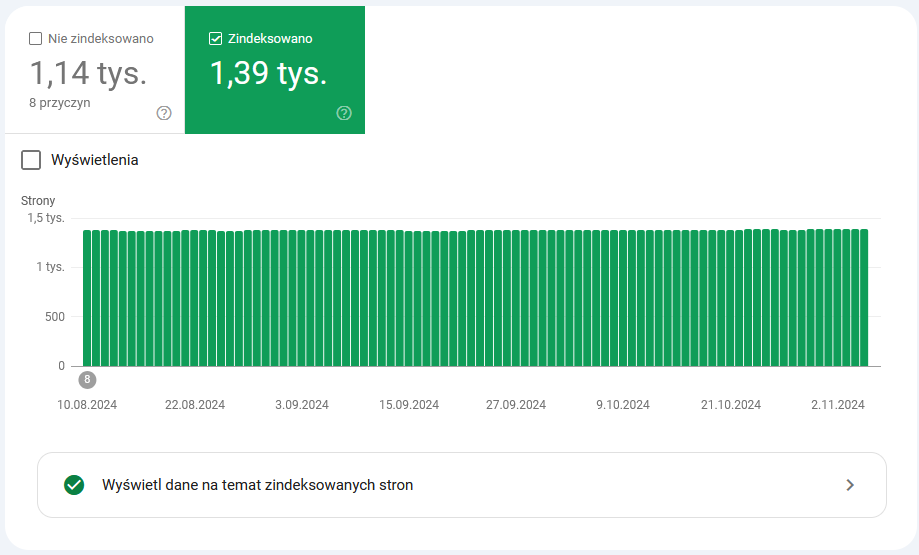

- W Google Serach Console

Darmowe narzędzie Google Search Console zawiera raport indeksowania stron, który pozwala sprawdzić, czy witryna jest indeksowana, a także ile podstron zostało objętych tym procesem.

Jak już pewnie się domyślacie, istnieją przypadki, gdy proces indeksowania jest utrudniony lub nawet niemożliwy. A może sami doświadczyliście tego typu problemu? Jeśli tak, to postaram się pomóc. W dalszej części artykułu omówię 6 najczęstszych przyczyn, przez które strona może nie pojawiać się w wynikach wyszukiwania.

Indeksacja zablokowana

Nie każdy właściciel witryny chce, aby jej zawartość była udostępniana i indeksowana przez wyszukiwarki. Oczywiście, ma do tego pełne prawo.

Istnieją zatem metody, które blokują indeksację. Problem jednak w tym, że czasami nie mamy takiego życzenia, a z różnych powodów strona zostaje zablokowana. Przykładem takiej sytuacji może być czas publikowania strony online, gdy jest ona przepinana z serwera testowego na produkcyjny. W takich przypadkach zdarza się, że możliwość indeksowania nie zostaje odblokowana.

Wróćmy jednak do meritum. Co należy sprawdzić, gdy okazuje się, że strona nie znajduje się w indeksie Google czy innej wyszukiwarki?

- Plik robots.txt

Warto sprawdzić zapisy w pliku tekstowym robots.txt. Plik ten może, ale nie musi istnieć. Jeśli jednak istnieje (pod adresem URL: „domena.pl/robots.txt”) i widnieje tam zapis w stylu:

User-agent: *

Disallow: /

oznacza to, że zabraniamy wyszukiwarkom dostępu do strony, a tym samym indeksowania.

Oczywiście istnieją różne inne kombinacje komend w tym pliku, które mogą zabraniać lub utrudniać proces indeksowania. Więcej o pliku robos.txt można poczytać na stronie https://developers.google.com/search/docs/crawling-indexing/robots/intro?hl=pl.

- Meta tag „robots”

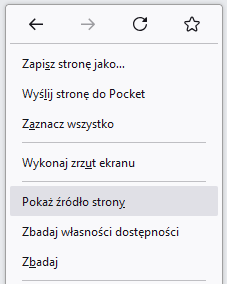

Weryfikacji wymaga również meta tag „robots”, który nie wyświetla się bezpośrednio na stronie, ale może być widoczny w jej źródle.

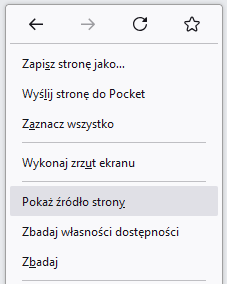

Jak to zrobić? Wystarczy, będąc na stronie w dowolnej przeglądarce, nacisnąć „Ctrl+u” lub kliknąć na nią lewym przyciskiem myszy i wybrać:

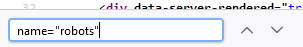

Zobaczymy wówczas wiele nieznanych nam znaczników, z których zbudowana jest strona. Korzystając z opcji „szukaj” wpiszmy:

Dzięki czemu znajdziemy linię kodu, o której mowa.

Jeśli wyświetli nam się kod w stylu:

oznacza to, że zabraniamy wyszukiwarkom indeksowania. Tutaj analogicznie jak wyżej, znacznik ten umożliwia różne kombinacje, o czym więcej przeczytasz na stronie https://developers.google.com/search/docs/crawling-indexing/robots-meta-tag?hl=pl.

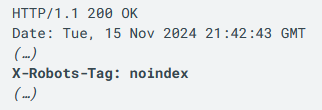

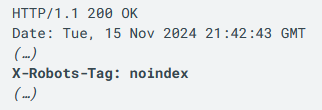

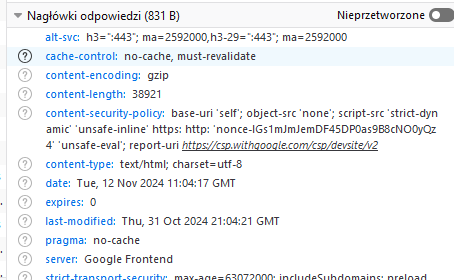

- X-Robots-Tag

Blokada indeksowania może także zostać zdefiniowana w nagłówkach (HTTP) zwracanych przez serwer, a dokładniej w nagłówku „X-Robots-Tag”. Jest to o wiele mniej popularna metoda, jednak w swojej karierze widziałem wiele takich przypadków.

Poniższy zapis powoduje automatyczną blokadę przez indeksowaniem:

Jak to sprawdzić?

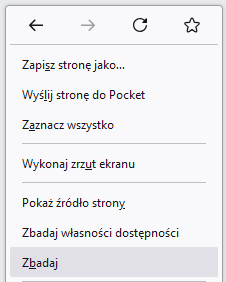

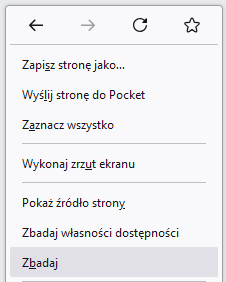

Najwygodniej będzie dotrzeć do omawianych nagłówków za pomocą narzędzi deweloperskich wbudowanych w każdą nowoczesną przeglądarkę. Będąc na badanej stronie, klikamy w nią prawym klawiszem myszy i wybieramy „Zbadaj”:

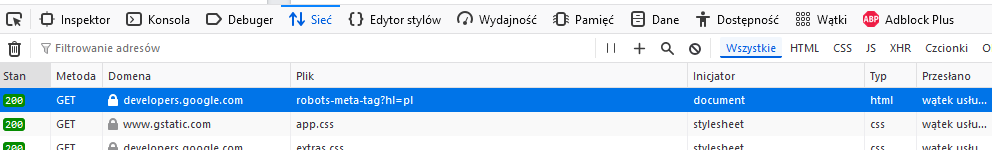

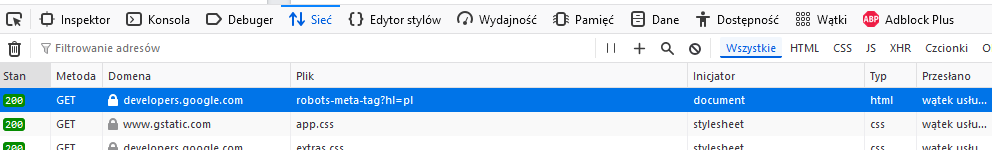

Z kolejnego menu wybieramy „Sieć/Network” i zaznaczmy pozycję prezentującą analizowaną stronę (typ HTML), np.:

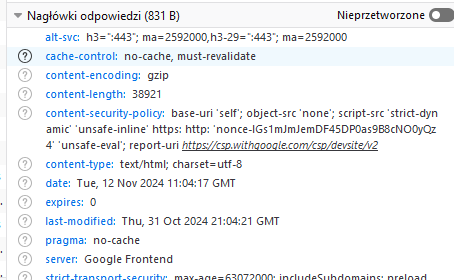

Po prawej stronie ukaże się nam okno, w którym można podejrzeć, jakie nagłówki zwróciła nam witryna:

Jak widać na powyższym przykładzie, nie pojawia się tutaj blokada indeksowania.

- Inne

Oprócz wyżej wymienionych przypadków, mogą występować inne powody nieindeksowania witryny, np. zablokowanie botów wyszukiwarek na poziomie pliku „.htaccess” lub w ramach filtrów Cloudflare, jednak ich weryfikacja może wymagać skontaktowania się z obsługą techniczną.

Jeśli sprawdziliśmy trzy pierwsze z powyższych punktów, a narzędzie Google Search Console nadal podpowiada, że istnieje problem z zaindeksowaniem witryny, potrzebna będzie specjalistyczna pomoc.

Brak odnośników z innych witryn

Aby witryna mogła zostać zindeksowana, boty wyszukiwarek muszą poznać jej adres URL i dowiedzieć się o jej istnieniu. Mimo zaawansowanych algorytmów, wyszukiwarki same nie odkryją strony. Musimy im ją „pokazać”. Ale jak to zrobić?

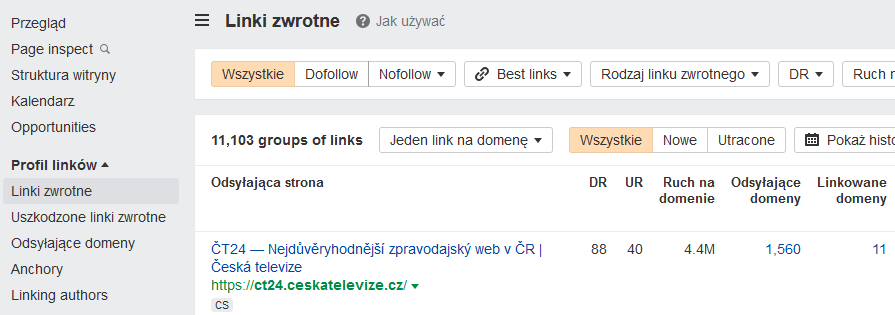

Naturalnymi drogami dla botów wyszukiwarek są odnośniki (tzw. linki) prowadzące z jednej witryny do drugiej, tworząc rozbudowaną sieć połączeń. Należy zatem poprowadzić co najmniej jedną z takich dróg do naszej strony. Warunkiem koniecznym jest umieszczenie odnośnika na stronie, którą boty już odwiedzają. Tylko w ten sposób wyszukiwarki będą w stanie przejść ze strony A na stronę B i w przypadku braku blokad, zindeksować ją.

Im więcej takich odnośników pojawi się w przestrzeni internetowej, tym częściej boty będą odwiedzać stronę, co przyspieszy proces jej indeksowania w wynikach wyszukiwania.

Jeśli zatem posiadamy stronę, bez stwierdzonych blokad indeksacji, a mimo wszystko nie widzimy jej w wynikach Google czy Bing, zweryfikujmy czy boty mają w ogólne szansę do niej dotrzeć.

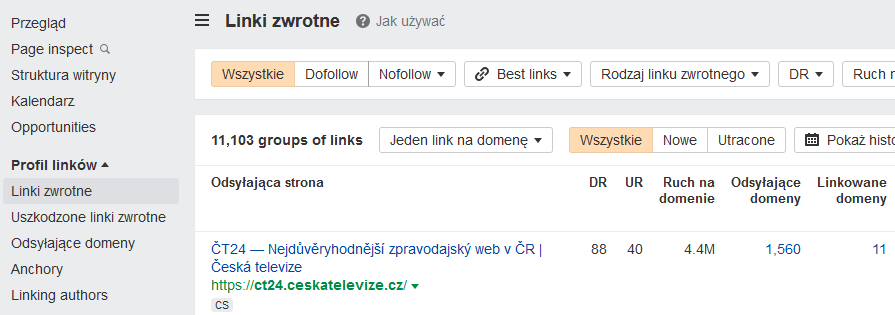

Zrobić to możemy za pomocą darmowego narzędzia Google Search Console (raport „Linki”) lub Bing Webmaster Tools, ale również i to nawet lepszy pomysł, za pomocą płatnych, zewnętrznych narzędzi, np. Ahrefs.com czy Majestic.com.

Nowa strona

Żadna nowa strona z domeną bez historii nie posiada linków zewnętrznych – jest niczym samotny dom pośród gęstego lasu. Im więcej dróg zbudujemy prowadzących do niego, tym większa szansa, że boty wyszukiwarek nas znajdą i zauważą.

Czasem takie linki pojawiają się w sposób naturalny (np. gdy nasz partner biznesowy umieści na swojej stronie link). Innym razem musimy wspomóc ten proces, dodając stronę np. do katalogu firm branżowych.

Wyjątek mogą stanowić domeny, które kiedyś były już wykorzystywane. Strona może być nowa, ale domena posiadać już pewną historię. Wówczas wcześniej „zdobyte” linki prawdopodobnie zapewnią nam sprawną indeksację.

Ważne, aby zdawać sobie sprawę, że proces indeksacji nie dzieje się natychmiastowo. Zanim boty wyszukiwarek znajdą naszą nową stronę i zechcą ją zindeksować, może upłynąć nawet kilka dni, a czasem i więcej. Szybkość indeksacji zależy bowiem od wielu czynników, o których doskonale wiedzą specjaliści SEO.

Nie dziw się zatem, jeśli po uruchomieniu nowej, starannie dopracowanej strony, nie znajdziesz jej w wynikach wyszukiwania. To naturalne. Jeśli upewniłeś się, że nie istnieje blokada przed indeksowaniem, a do strony prowadzą linki zewnętrzne, uzbrój się w cierpliwość. Odczekaj kilka dni i sprawdź sytuacje ponownie.

Błędy i problemy techniczne na stronie

Powodem nieindeksowania witryny mogą być różnego rodzaju problemy, czy błędy na niej występujące. I tutaj podzieliłbym temat na dwie możliwości:

- Strona z problemami, ale bez wyraźnej blokady dla botów wyszukiwarek

Jeśli wyszukiwarki „stwierdzą”, że Twoja strona jest uszkodzona, to również mogą uznać, że nie ma sensu jej wyświetlać Użytkownikom końcowym. Tak między nami – ma to sens, gdyż witryna, która nie spełnia swojej funkcji, staje się bezużyteczna, a kluczowe jest przecież dostarczanie wartości dla użytkownika.

Mechanizmy wyszukiwarek skutecznie wyłapują różnego rodzaju problemy występujące w witrynach, np. atak hakerski czy skrajnie wolne jej wczytywanie się w przeglądarkach Użytkowników i dopasowuje swoje działania do zastanego stanu.

- Strona z problemami, które uniemożliwiają zindeksowanie

Mogą istnieć także problemy całkowicie uniemożliwiające wyszukiwarkom indeksowanie. Efektem może być właściwie blokada opisana wyżej (podpunkt: „d. Inne”), której źródło niełatwo jest zlokalizować. Trudno mi podać jednoznaczne przykłady, ponieważ zazwyczaj dotyczą one bardzo indywidualnych sytuacji, a czasami wynikają z nałożenia się kilku różnych problemów.

Jednym z takich przykładów może być niewłaściwa implementacja systemu przekierowań (redirects), które powodują ich łańcuch, w ramach którego na pewnym etapie boty napotykają na problem nie do przejścia.

W tego typu przypadkach konieczna jest pomoc specjalisty o znacznym doświadczeniu, a czasami nawet zespołu specjalistów.

Czy jest co indeksować?

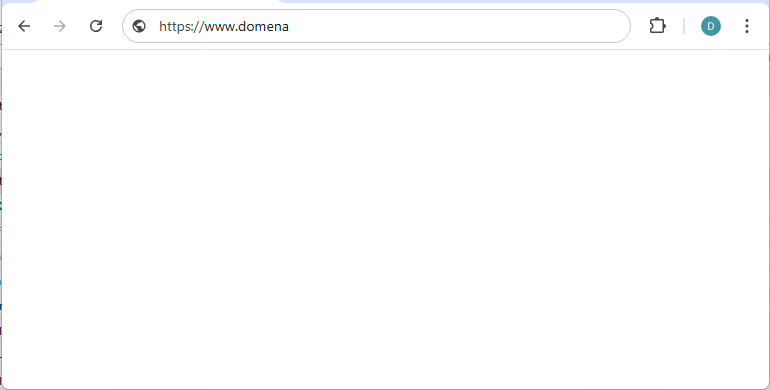

Aby strona mogła zostać zindeksowana, wyszukiwarki muszą widzieć treść, jej zawartość w formie tekstów, elementów graficznych, nawigacyjnych etc.

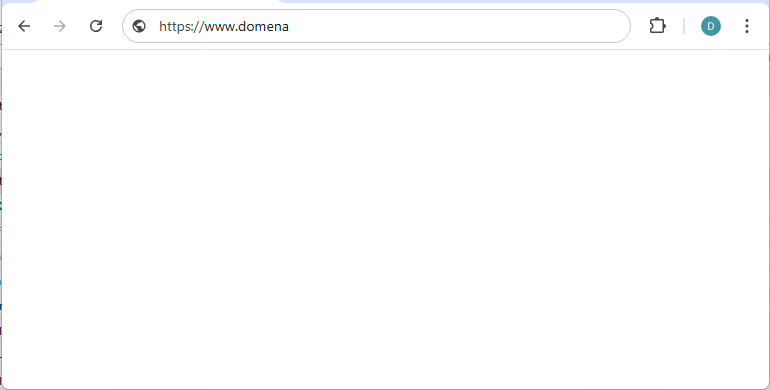

Nie zawsze to, co widzimy w przeglądarkach my jako Użytkownicy, „widzą” również wyszukiwarki. Czasami te widoki mogą się diametralnie różnić – dla nas wyświetla się estetyczna, dopracowana pod kątem SEO i UX strona, podczas gdy boty mogą odbierać ją np. jako pustą:

Przytoczyłem tutaj dość skrajny przypadek, ale takie sytuacje naprawdę się zdarzają, zwłaszcza gdy strona opiera się na technologii nieprzyjaznej SEO, trudnej do poprawnego zinterpretowania przez wyszukiwarki lub wdrożonej w sposób niespełniający wymogów SEO.

Pierwszy przykład, który przychodzi mi do głowy to strony oparte na JavaScript, który w wielu przypadkach nie sprawia problemu wyszukiwarkom, a wręcz odwrotnie – jest nieocenionym narzędziem do budowania nowoczesnych i użytecznych witryn.

W swojej zawodowej karierze spotykałem jednak przypadki, gdy niewłaściwie lub nieprzemyślane wykorzystanie JS powodowało brak indeksacji.

Jeśli zatem niepokoi Was ciągły brak indeksacji witryny, a powody opisane wyżej wyeliminowaliście na wcześniejszym etapie analizy, warto zweryfikować, w jaki sposób Google „widzi” Waszą stronę.

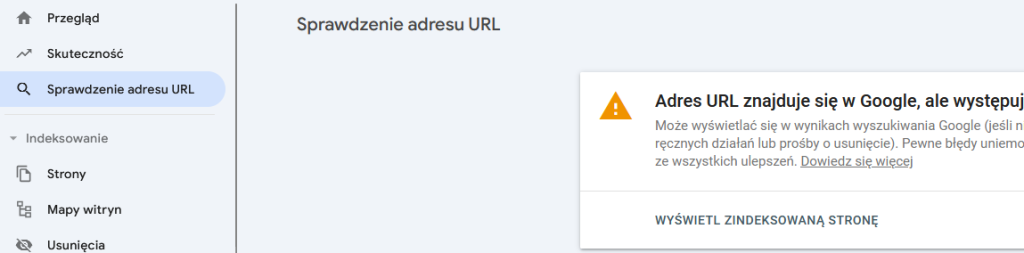

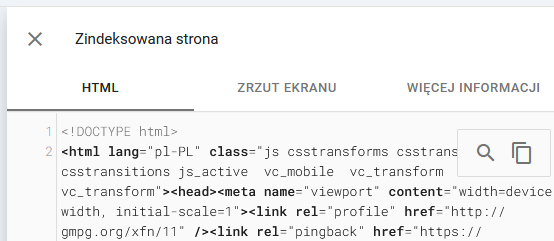

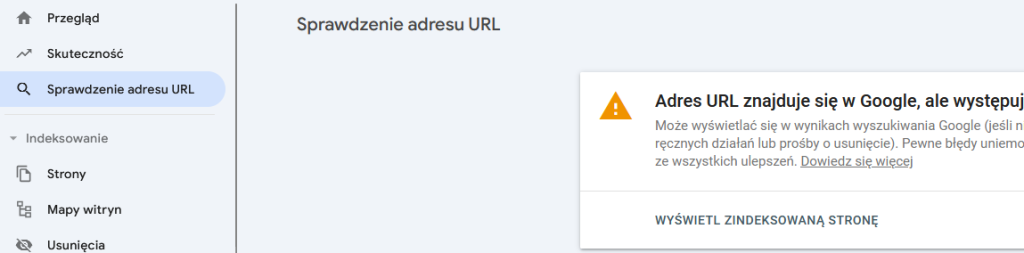

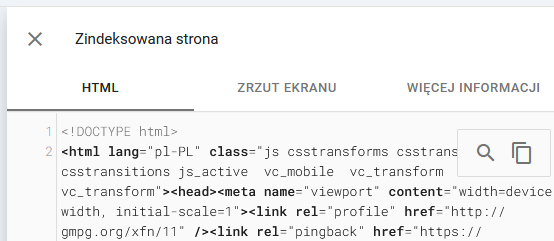

Nieocenionym narzędziem do tego jest wspomniane już wielokrotnie Google Serach Console, gdzie w raporcie „Sprawdzenie adres URL” należy wpisać adres URL strony:

I poczekać chwilę na weryfikację.

Następnie klikamy w przycisk „Wyświetl zindeksowaną stronę”, po czym możemy upewnić się w jakiej postaci źródło witryny „widzi” Google, a czasem także zobaczyć zrzut ekranu:

Niskie pozycje

5 powyższych punktów dotyczy problemów z indeksacją, których efektem jest zupełny brak widoczności w wynikach wyszukiwania.

Często jednak mówiąc „strona się nie indeksuje”, mamy na myśli niemożność odnalezienia naszej strony w wynikach wyszukiwania, a to zupełnie inny temat i inaczej należy do niego podejść.Niekoniecznie strona jest wówczas niezindeksowana, ale może po prostu zajmować niższe pozycje na wpisywane przez nas frazy kluczowe.

Przy tego typu problemach w grę wchodzi konkurencyjność danej branży, stopień zoptymalizowanie witryny pod kątem SEO, jakość profilu linkowania zewnętrznego, autorytet strony oraz wiele innych czynników, nad którymi na co dzień pracują specjaliści SEO Ideo Force.

Stała opieka SEO nad stroną, obejmuje nie tylko pracę nad wspomnianymi czynnikami, ale także nad wieloma innymi aspektami, które same w sobie mogłyby stanowić temat oddzielnego artykułu.

Niniejszy poradnik ma na celu pomoc w zidentyfikowaniu najczęstszych przyczyn, które mogą prowadzić do braku widoczności strony w wyszukiwarkach internetowych. Jeśli jednak odnalezienie źródła problemu okaże się zbyt trudne, zapraszamy do skorzystania z konsultacji z naszym specjalistą SEO.

Podsumowanie

Widoczność strony internetowej w wyszukiwarce zależy od wielu czynników, a w tym od aspektów technicznych oraz odpowiedniego stosowania wiedzy o działaniu algorytmów. Nowe witryny, bez historii i linków zewnętrznych, wymagają dodatkowej uwagi i czasu, aby zostały zauważone przez boty wyszukiwarek. Problemy z technologiami czy błędy w kodzie mogą z kolei sprawić, że nawet dobrze zaprojektowana witryna będzie niewidoczna. Zrozumienie tych mechanizmów i ich potencjalnych przyczyn to klucz do budowania widoczności w sieci.

CSR jako narzędzie marketingowe dla MŚP

CSR jako narzędzie marketingowe dla MŚP

Postępowanie sądowe z udziałem konsumentów. Obowiązki przedsiębiorcy

Postępowanie sądowe z udziałem konsumentów. Obowiązki przedsiębiorcy

Co mówią dane? 5 raportów analitycznych Twojej strony, które powinieneś znać

Co mówią dane? 5 raportów analitycznych Twojej strony, które powinieneś znać

Polska Spółka Holdingowa – jakie preferencje podatkowe przewiduje ustawa o CIT?

Polska Spółka Holdingowa – jakie preferencje podatkowe przewiduje ustawa o CIT?